Η χρήση του ChatGPT στην Ευρώπη έχει αυξηθεί ραγδαία, αλλά η Ευρωπαϊκή Ένωση καθυστερεί να αποφασίσει πώς θα το εντάξει στο ισχύον ρυθμιστικό πλαίσιο. Προθεσμία μέσα στο 2026 αναμένεται για την απόφαση της Κομισιόν σχετικά με την εφαρμογή του Digital Services Act, ενώ ταυτόχρονα το μοντέλο διέπεται ήδη από τον AI Act.

Προθεσμίες και αριθμοί χρηστών

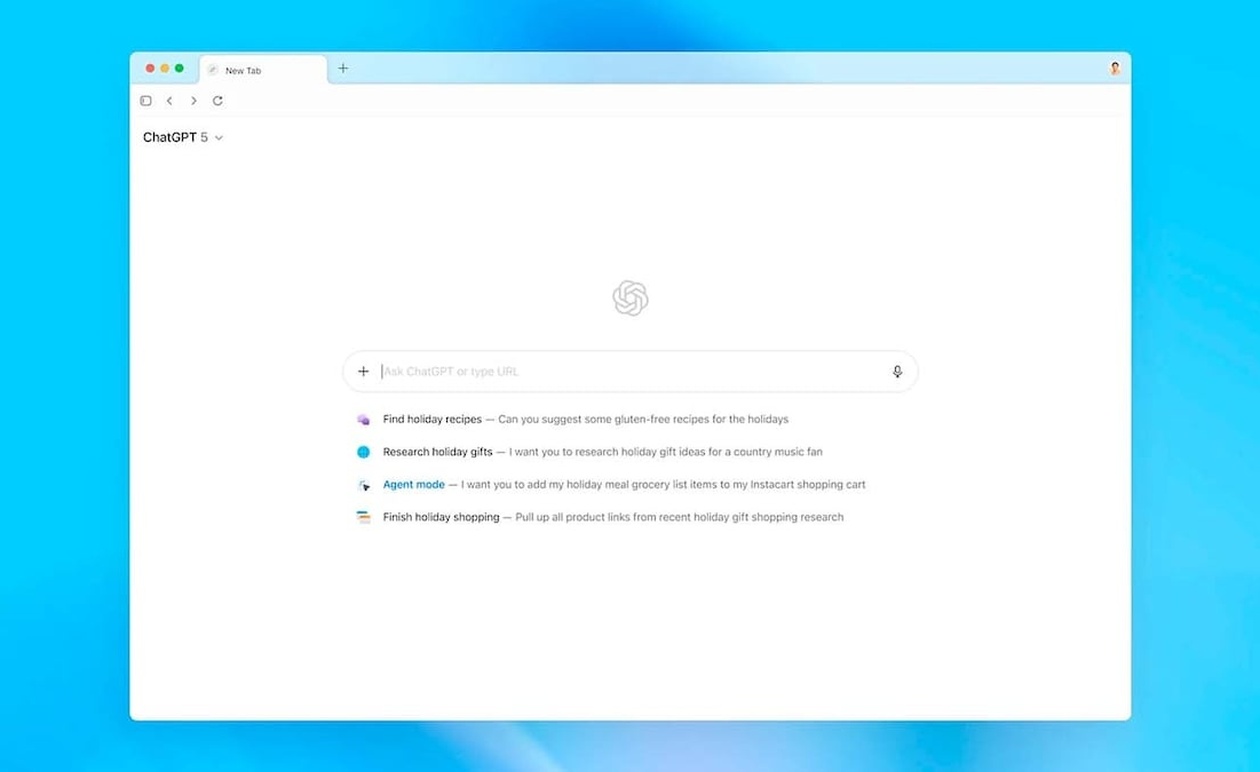

Η OpenAI ανακοίνωσε ότι περισσότερα από 120 εκατομμύρια άτομα χρησιμοποιούν τη δυνατότητα αναζήτησης του ChatGPT κάθε μήνα, αριθμός που, σύμφωνα με πληροφορίες του POLITICO, ήταν γνωστός στην Κομισιόν. 45 εκατομμύρια χρήστες το μήνα αποτελεί το όριο για να θεωρηθεί μία υπηρεσία «πολύ μεγάλη» υπό τον DSA, και τα νέα στοιχεία την φέρνουν πάνω από αυτόν τον δείκτη.

Μια πιθανή επίσημη οριοθέτηση αναμένεται σε μέσα του 2026, σύμφωνα με δηλώσεις αξιωματούχων. Αν υπάρξει τέτοια απόφαση, οι υποχρεώσεις που επιβάλλει ο DSA θα αρχίσουν να ισχύουν για την πλατφόρμα σε επόμενο στάδιο, με χρονικές συνέπειες στην εφαρμογή των απαιτήσεων συμμόρφωσης.

Δύο νομικά πλαίσια με διαφορετικούς στόχους

Το ChatGPT υπάγεται ήδη στον AI Act, που απαιτεί αξιολόγηση κινδύνων και μέτρα μετριασμού, με ενδεχόμενη επιβολή προστίμων μέχρι €15 εκατομμύρια σε περίπτωση μη συμμόρφωσης. Ο DSA, από την άλλη, στοχεύει σε πολύ μεγάλες πλατφόρμες και μηχανές αναζήτησης με διαφορετικές νομικές απαιτήσεις.

Οι δύο νόμοι λειτουργούν με διαφορετικά πλαίσια κινδύνου: ο AI Act κατηγοριοποιεί μοντέλα ανάλογα με τον βαθμό κινδύνου, ενώ ο DSA εστιάζει σε «συστημικούς κινδύνους» όπως οι επιπτώσεις στην εκλογική διαδικασία και τη δημόσια υγεία. Αυτή η διάταξη δημιουργεί πρακτικά ζητήματα στην εφαρμογή όταν μία υπηρεσία συνδυάζει χαρακτηριστικά πλατφόρμας και μοντέλου τεχνητής νοημοσύνης.

Πεδίο οριοθέτησης της υπηρεσίας

Η Επιτροπή μπορεί να αποφασίσει να περιορίσει την εκτίμησή της μόνο στις λειτουργίες αναζήτησης του ChatGPT ή να επεκτείνει την οριοθέτηση στο σύνολο της υπηρεσίας. Μία στενή ερμηνεία θα αντιμετώπιζε το εργαλείο ως μηχανή αναζήτησης, ενώ μία ευρύτερη θα το κατέτασσε ως πλατφόρμα ή υπηρεσία πάνω στο μεγάλο γλωσσικό μοντέλο.

Η έκταση της οριοθέτησης επηρεάζει επίσης τις τεχνικές απαιτήσεις: για παράδειγμα, ως μηχανή αναζήτησης η υπηρεσία μπορεί να εξαιρεθεί από συγκεκριμένες δεσμευτικές υποχρεώσεις, όπως ο μηχανισμός ειδοποίησης για αναφορές περιεχομένου, που απαιτείται για άλλες πλατφόρμες.

Κίνδυνοι, ευθύνες και τεχνικές απαιτήσεις

Η OpenAI έχει παραδεχθεί ότι περίπου 1,2 εκατομμύρια συνομιλίες την εβδομάδα δείχνουν προθέσεις αυτοκτονίας ή αυτοβλάβης, στοιχείο που αναδεικνύει την ανάγκη για ειδικά μέτρα προστασίας. Η αξιολόγηση των κινδύνων θα πρέπει να καλύψει θέματα όπως η επιρροή στην εκλογική διαδικασία και τη δημόσια υγεία, εφόσον αυτά εντάσσονται στο πεδίο εφαρμογής.

Ο DSA προβλέπει ότι οι εκθέσεις συμμόρφωσης πρέπει να περιλαμβάνουν στοιχεία για τον σχεδιασμό συστημάτων αλγοριθμικής σύστασης, κάτι που γίνεται πιο περίπλοκο αν η αξιολόγηση στοχεύει στο ίδιο το μεγάλο μοντέλο γλώσσας και όχι μόνο στο περιεχόμενο που προβάλλεται στους χρήστες.

Αναμενόμενες συνέπειες για την OpenAI

Εάν η Επιτροπή ορίσει την υπηρεσία ως VLOP/VLOSE κάτω από τον DSA, η OpenAI θα μπορούσε να υποστεί πρόστιμα που φτάνουν σε ποσοστό έως 6% των εσόδων σε περίπτωση σοβαρής παραβίασης. Παράλληλα, θα χρειαστεί να υποβάλει εκτενείς εκθέσεις συμμόρφωσης και να λάβει μέτρα μετριασμού κινδύνων.

Ειδικοί νομικοί σχολιάζουν ότι ο DSA μπορεί να αποτελέσει «σκληρό ξύπνημα» για εταιρείες που στηρίζονται σε αυτορρυθμιζόμενα πρότυπα. Συγκεκριμένα, ο Mathias Vermeulen αναφέρει ότι η εφαρμογή του DSA θα απαιτήσει από την OpenAI σημαντική αναβάθμιση των πρακτικών της, και ότι δεν αρκεί μόνο μια τυπική προσαρμογή των υπαρχόντων μέτρων.

Προβλήματα συντονισμού μεταξύ νόμων

Ειδικοί όπως ο João Pedro Quintais επισημαίνουν ότι ο DSA και ο AI Act δεν έχουν σχεδιαστεί για παρόχους που είναι κάθετοι και ενσωματώνουν τα ίδια μοντέλα στις υπηρεσίες τους. Αυτό μπορεί να δημιουργήσει κενά στην αξιολόγηση του κινδύνου, αφού ο τρόπος που αντιμετωπίζεται η παραπληροφόρηση από τον DSA μπορεί να διαφέρει από την προσέγγιση του AI Act.

Στην πράξη, κάποιες λειτουργίες που εντάσσονται στον DSA, όπως η αντιμετώπιση deepfakes και παραπληροφόρησης, θα ρυθμιστούν κυρίως από τον DSA, ενώ άλλες χρήσεις του μοντέλου, για παράδειγμα σε διαδικασίες πρόσληψης, θα παραμείνουν κάτω από τον AI Act.

Δυνατότητα αντιπαράθεσης και επόμενα στάδια

Εάν η Επιτροπή αποφασίσει να εντάξει το ChatGPT στον DSA, η OpenAI ενδέχεται να αμφισβητήσει την απόφαση, όπως έχουν επιχειρήσει στο παρελθόν άλλοι πάροχοι υπηρεσιών. Μια τέτοια προσφυγή θα μπορούσε να παρατείνει την τελική εφαρμογή των απαιτήσεων.

Η τελική απόφαση θα καθορίσει ποια μέτρα πρέπει να εφαρμόσει η εταιρεία για να μειώσει συστημικούς κινδύνους και πώς θα ελέγχεται η συμμόρφωση, με την Επιτροπή να διαθέτει πλέον τα στοιχεία χρήσης που θέτουν το ζήτημα στο επίκεντρο της ρυθμιστικής ατζέντας.